Näin sydäntalvella on aikaa miettiä laatuasioita, kun lumipeite estää monen maastokohteen mittauksen. Laatu on nyt tapetilla alalla kuin alalla, mistä syystä MIKESin entinen ylijohtaja Timo Hirvi kommentoi myös laadun tilaa Suomessa (HS maksumuuri). Hän kertoi muun muassa Suomen jääneen jumbosijalle ASQ-laatuorganisaation edellisessä kansainvälisessä laatuvertailussa vuonna 2016 ja epäilee ”suomalaisen laadun” olevan pääosin harhaa. Ainakin niissä tapauksissa, jossa hinta on hankinnan määräävin tekijä. Hän toteaa myös: ” Hyvä laatu ei ole itsestäänselvyys. Kysymys on ammattitaidosta, laatuun vaikuttavien asioiden ymmärtämisestä ja moraalista. ”

Meilläkin mittauksen ja koko mittausprosessin laatuasiat ovat säännöllisesti keskusteluissa uusien ja vanhojen tapausten myötä. Nostamme tässä esille muutaman meillä keskustellun aihepiirin, jotka ovat sinänsä vain pieni iso isommassa kokonaisuudessa, mutta toisaalta niitä perusosia, joista isoa kokonaisuutta lähdetään rakentamaan.

1) Runkomittauskeskusteluun liittyen keskustelimme geodesian professori Matti Martikaisen tasoituslaskuluennoista, joilla aikoinaan kävi hyvin selväksi, ettei tasoituslaskennalla paranneta virheitä eli toisin sanoen laskennan pohjana käytettäviä havaintoja. Mittausta tehdessä huonoja havaintoja ei siis parannella tasoittamalla ja virheen suuruus on arvioitava ennen tasoituksen tekemistä. Itse tasoitus on lähinnä tyylittelyä. Jos kokonaisvirhe (epävarmuus) on käyttötarkoitusta ajatellen liian suuri, niin havainnot on mitattava uudestaan. Martikainen taisi korostaa aihetta sen takia, että mittauksen kentältä alkoi korkeakoulullekin valua tietoa tulosten ”parantamisesta”.

2) Maassa tai ilmassa tehtävät mobiililasermittaukset ovat olleet jatkuvan keskustelun kohteemme viime vuosina. Geodesian perussäännöt pätevät hyvin myös laserkeilaushavaintoihin tai oikeastaan jo prosessoinnin alkuvaiheessa tehtävään ajo-/lentolinjan prosessointiin. Jos se ei onnistu mittaustyössä vaaditulla laatutasolla, niin on aivan turhaa yrittää parantaa lopputulosta laserlinjojen mätsäyksellä. Itse asiassa lento-/ajolinjojen mätsäys on tarpeeton toimenpide, jos laitteet ovat kunnolliset ja niitä käytetään oikein. Samoin kuin tasoituslaskennassa, virheanalyysi tehdään ennen mätsäystä, jotta ymmärretään lopputuloksen laatu tarkkuuden osalta eli mätsäys on vain hienosäätöä.

Toisin sanottuna jos aineistoissa on ”paljon mätsättävää”, niin silloin ne on oletettavasti tuotettu huonotasoisilla tai huonosti käytetyillä mittauslaitteilla. Esimerkiksi Rieglin laaduikkaimilla laitteistoilla trajektorien pitää olla maksimissaan vain parin sentin etäisyydellä toisistaan ennen mätsäystä, jos aiotaan saavuttaa moneen suunnittelutehtävään tarvittava mittaustarkkuus. Tällainen lopputulos erityyppisissä olosuhteissa vaatii kuitenkin työn huolellisen suunnittelun ja toteutuksen.

Jos esitellään kuinka hyvin jokin ohjelma murjoo paikalleen kaikki pahastikin harittavat linjat tai parantaa huonojen havaintojen laatua huomattavast, niin tällöin hälytyskellojen pitäisi soida mittauskoulutuksen saaneen ihmisen päässä. Pahasti harhailevatkin linjat voidaan ohjelmallisesti mätsätä yhteen, mutta missä pisteet oikeasti sijaitsevat onkin erinomainen kysymys. Jos laskennassa käytetään kontrollipisteitä, niin niiden virheistä ei myöskään voi päätellä mitään muuta kuin ohjelmankehittäjän taito minimoida virhe kontrollin kohdalla. Mittausaineistojen virheen suuruus arvioidaan siis ennen mätsäystä.

Koska vallitseva uskonkappale kertoo softalla ja tekoälyllä parannettavan kaiken, niin myös mittausalan viimeaikainen ohjelmistokehitys tuntuu keskittyvän aineistojen kaunisteluun oikean laskennan kehittämisen sijaan. Onhan se pistepilvienkin kohdalla ihan selvä asia, että mitä kauniimpi aineisto niin sen parempi se on myös geometriselta tarkkuudeltaan. Paitsi ettei ole.

Robotiikan puolelta tulleita SLAM-tekniikoita (joissa tyypillisesti kaikki eri sensorien tuottamat havainnot prosessoidaan yhdessä prosessissa), koskevat muuten käytännössä aivan samanlaiset periaatteet.

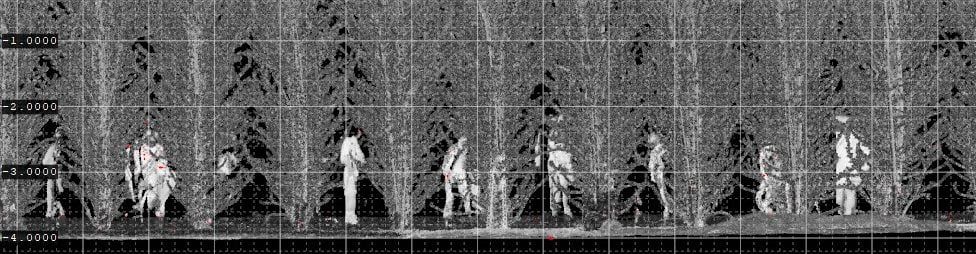

3) Ns. tekoälyalgoritmit mittauksessa. Laatuun liittyen olisi syytä herättää myös keskustelua uusien tekoälyalgoritmien käytöstä kaikenlaisten mittaushavaintojen laskennassa. Käytännössä murskaamme uusilla algoritmeillä vain entistä suurempia aineistoja. Kuten jo muiltakin aloilta tiedetään, niin tässä kehityksen vaiheessa kannattaa tietää aika tarkalleen mitä tekoäly tekee ettei tapahdu kummia. Nykymaailmassa tarvitsee siis muun muassa tietää, millaisilla aineistoilla ja periaatteilla algoritmia on koulutettu. Tätä aihepiiriä on käsitellyt hieman muun muussa Rieglin tuotekehitysjohtaja Andreas Ullrich artikkelissaan ”Noisy LIDAR point clouds: impact on information extraction in high-precision LIDAR surveying”. viitaten Nvidian karismaattinen perustajan Jen-Hsun Huangin esitykseen vuonna 2017. Huang näytti loistavia lopputuloksia kuvista tehdyn mallin visuaalisessa parantamisessa, mutta mikä on geometrinen todellisuus parantamisen jälkeen? Se tuskin edes kiinnostaa Huangia, koska hänen työnsä käyttötarkoitus on erilainen.

Kaiken kaikkiaan interneistä löytyy nykyisin lukuisia artikkeleita vastaavasta työstä, kuten tämä ETH:sta tuleva tutkimus kohinaisten ja harvojen pistepilvien muuntamisesta siloisiksi pintamalleiksi syvien neuroverkkojen avulla. Voimmeko luottaa näiden algoritmien toimimiseen esimerkiksi maaston mallintamisessa? Tätä kirjoittaessa emme tyypillisesti voi, joten riskien hallinnassa ja laadun valvonnassa on parasta ottaa käyttöön lääketutkimuksen alaltakin tuttu varovaisuusperiaate.

Tutkimusta ja kehitystä huonojen aineistojen parantamiseksi on valtavan paljon ja valitettavasti loppukäyttäjä on useimmiten eniten vaatimassa näitä funktioita aineistoilleen. Tämän todellisuuden huomaa erityisen selkeästi avointen foruminen keskusteluista, jossa ohjelmistokehittäjille lähetään mitä hurjemman näköisiä aineistoja. Siloittelun jälkeen ne tuntuvat kelpaavan vaikkapa tiemittauksen tarpeisiin – mittaustarkkuuksiin fiksu ohjelmistokehittäjä ei kuitenkaan ota kantaa. Oletettavasti moni tilaaja maailmalla ei tee kovin ihmeellistä laadunvalvontaa tilaamilleen tuotteille, jos perunapellosta siloitellut tienpinnat kelpaavat lopputuotteiksi.

Käytännössä on selvää, että uusin aalto tekoälyalgoritmien kehittämisessä ja käyttöönotossa virittää myös pohjaa laatukirjojen ja standardien päivittämieen.